使用Ollama+Lobechat部署本地AI助手

昨天看到朋友搞了个自己的ai,我也有点蠢蠢欲动了,于是便自己也看了看教程部署了一下自己本地的ai

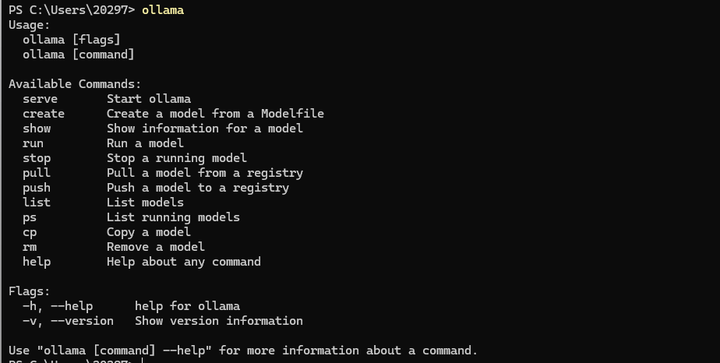

下载Ollama

https://ollama.com/ 在ollama官网下载ollama 安装完成后在终端输入ollama,显示下图则说明安装成功

img

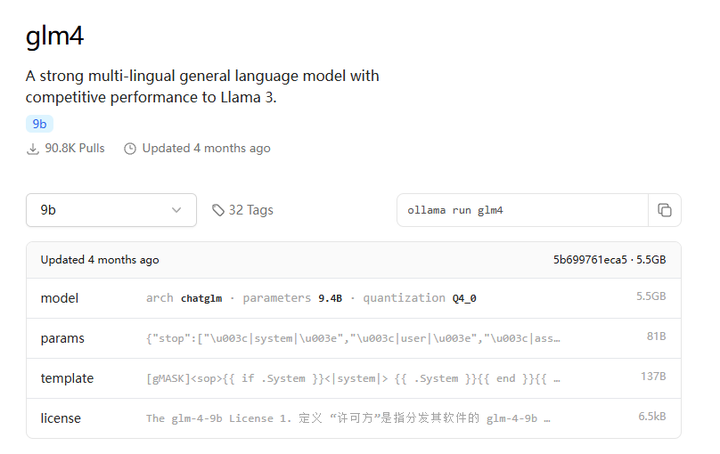

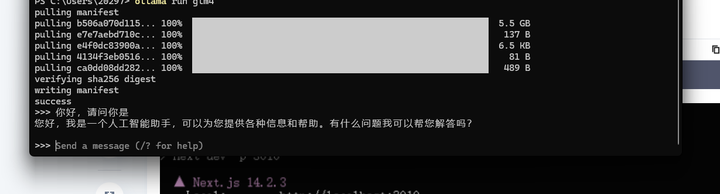

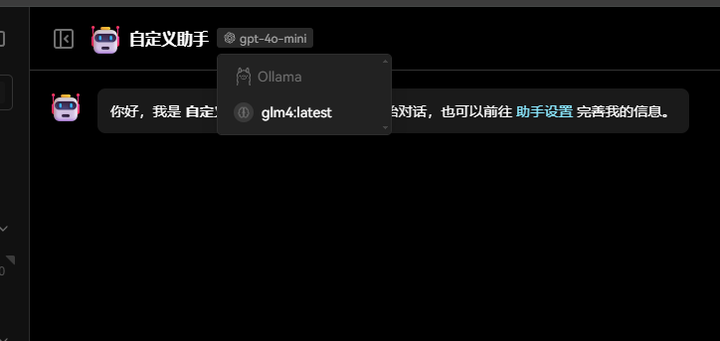

点击Ollama里面的Models,选择自己想要下载的模型,我这里选择的是glm4

img

img

下载lobechat

在windows下安装lobechat首先需要安装WSL 具体安装方法请自行上网查询

然后就是要安装Docker-Desktop,官网链接

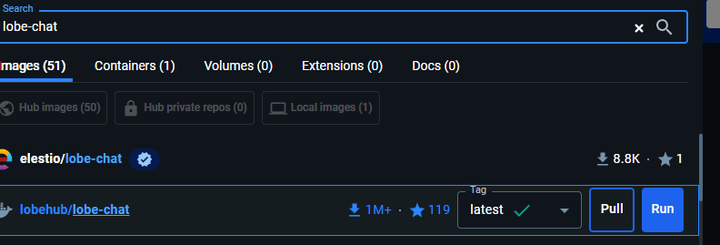

在中间的搜索框搜索lobe-chat找到lobehub/lobe-chat并pull

img

docker run -d -p 3210:3210 -e OPENAI_KEY=sk-xxx -e ACCESS_CODE=lobe66 --name lobe-chat lobehub/lobe-chat进行启动,就可以在http://localhost:3210/这里访问了

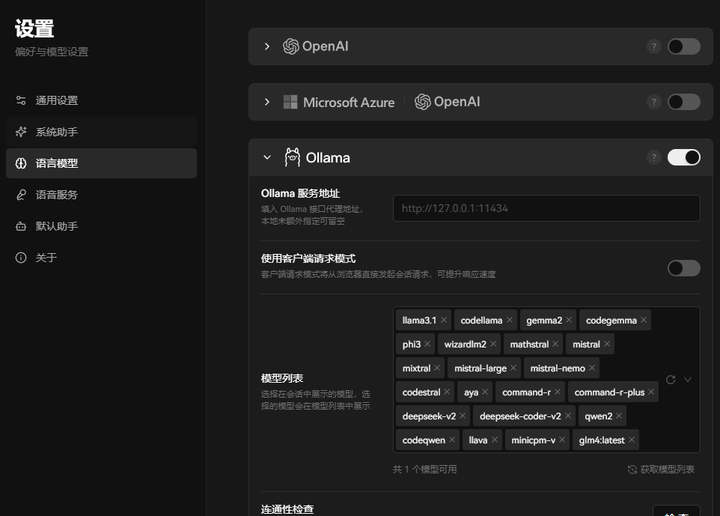

进入这里之后点击左上角的头像,点击设置

img

img